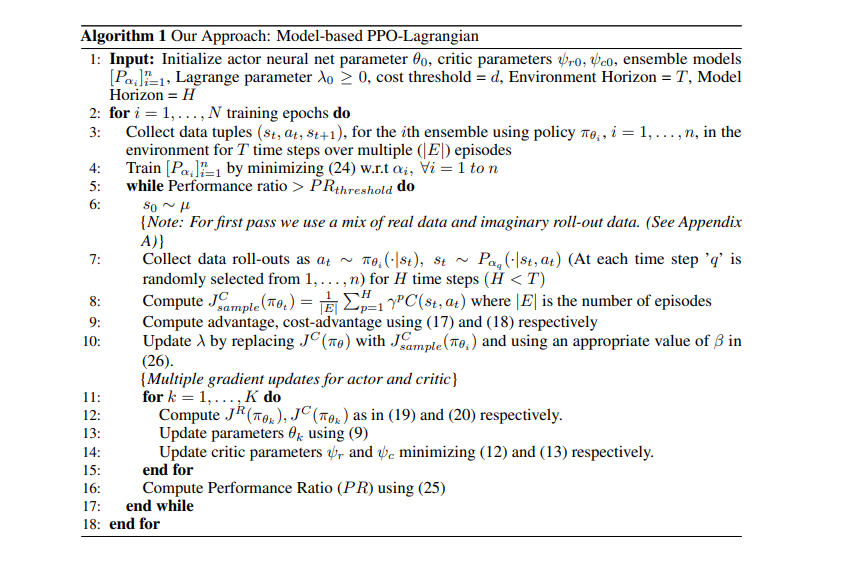

在大多数强化学习(RL)算法的初始训练迭代期间,智能体执行大量随机探索步骤。在现实世界中,这可能会限制这些算法的实用性,因为它可能导致潜在的危险行为。因此,安全探索是在现实世界中应用RL算法的关键问题。这一问题最近在约束马尔可夫决策过程(CMDP)框架下得到了很好的研究,在该框架中,除了单阶段奖励外,智能体还根据状态转换接收单阶段成本或惩罚。规定的成本函数负责将任何给定时间步长的不期望行为映射到标量值。然后,我们的目标是找到一个可行的政策,在培训和部署期间,最大限度地提高回报,同时将成本回报限制在规定的阈值以下。我们提出了一种基于策略模型的安全深度RL算法,在该算法中,我们在线学习环境的过渡动态,并使用基于拉格朗日松弛的邻近策略优化来找到可行的最优策略。我们使用具有不同初始化的神经网络集合来解决环境模型学习过程中面临的认知和任意不确定性问题。我们使用具有挑战性的安全强化学习基准-开放式人工智能安全健身房,将我们的方法与受限RL中的相关无模型和基于模型的方法进行比较。我们证明,与约束无模型方法相比,我们的算法具有更高的样本效率,并导致更低的累积风险违规。此外,我们的方法比文献中其他基于约束模型的方法表现出更好的奖励性能。

深度强化学习在离散动作设置[Mnih等人,2013年]和连续动作域(如运动任务[Haarnoja等人,2018年]、[Schulman等人,2017年]、[Chulman等人,2016年]的情况下都提供了优异的结果。然而,大多数RL算法在学习和部署期间执行大量随机探索步骤,这可能导致代理执行不期望的和危险的行为。这限制了RL算法在现实世界中的应用。在机器人导航[Han等人,2018]、自动驾驶[Kendall等人,2019]、医疗保健[Yu等人,2020]等场景中,RL具有潜在的应用,不安全行为甚至会对人的生命和财产造成危险后果。在García等人[2015]中,作者对几种安全概念和相关问题公式进行了全面调查。在我们的工作中,我们专注于基于约束的安全概念。在基于约束的RL中,目标是最大化长期预期回报,并将预期成本回报保持在规定的阈值以下。这个问题被称为安全勘探问题。在[Ray等人,2019]中,作者主张安全规范应与任务性能规范分开。它也有助于将安全勘探制定为一个约束优化问题,优化文献[Bertsekas,1996]中使用的方法可用于解决该问题。约束马尔可夫决策过程(CMDP)[Altman,1998]提供了一个框架,使任务性能规范和安全规范彼此分离。在这里,除了单阶段奖励,状态转换也会收到单阶段成本。规定的成本函数负责将任何给定时间步长的不期望行为映射到非负标量值。约束RL设置中使用的现有无模型算法在环境交互方面存在样本效率低的问题,即,这些算法需要大量的环境交互(收敛),而这些交互又会由于不安全的勘探而导致大量的危险行为。这是我们对受限RL使用基于模型的方法的动机。